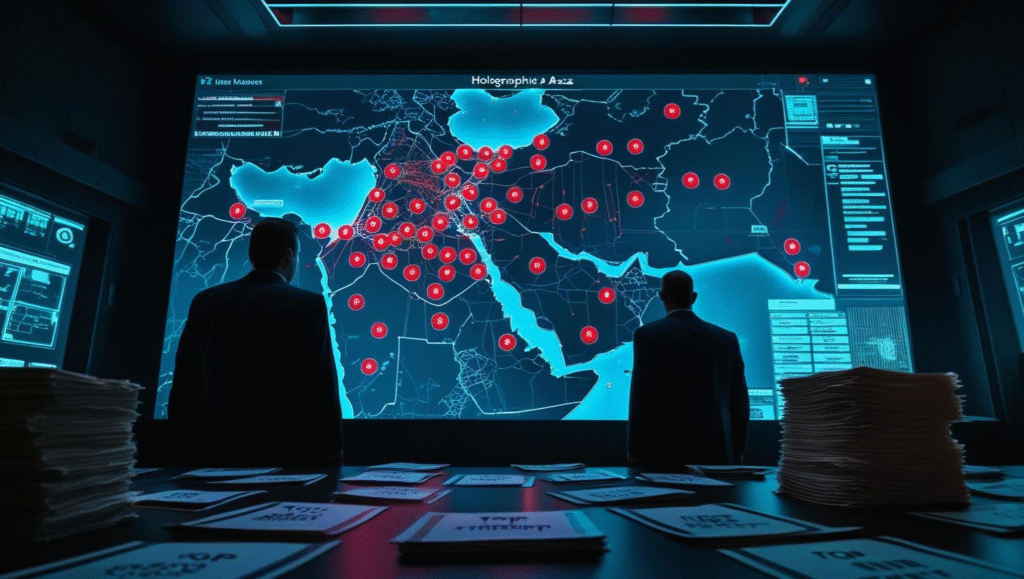

U srcu aktuelnog rata u Gazi, jedan detalj je izazvao paniku među stručnjacima za ljudska prava: Izraelska vojska koristi AI sisteme da automatski identifikuje mete – i odlučuje ko živi, a ko umire.

Ova tvrdnja potiče iz istrage koju su sproveli +972 Magazine i Local Call, pozivajući se na anonimne izvore iz izraelskih obaveštajnih i vojnih struktura.

Šta su „Gospel“ i „Lavender“?

- „Lavender“ je AI sistem za klasifikaciju i identifikaciju članova Hamasa. U roku od sekundi analizira ogromne baze podataka i kreira „listu za likvidaciju“ na osnovu digitalnog traga osobe (SIM kartice, lokacija, poruke).

- „Gospel“ je AI sistem koji na osnovu podataka iz više izvora potvrđuje da je meta „validna“ – dakle da se nalazi tamo gde se očekuje.

Ove „mašine“ mogu generisati stotine meta dnevno, automatski, uz minimalnu ljudsku intervenciju. Problem? Nije uvek jasno ko tačno donosi odluku – čovek ili algoritam.

Etika ili genocid?

Prema izveštajima, često su napadi odobravani bez prethodne provere – na osnovu AI „pretpostavki“. Rezultat? Hiljade mrtvih civila, uključujući žene i decu, često kao „kolateralna šteta“ jer su borci Hamasa živeli u stambenim zgradama.

„Ovo je masovna mašina za ubistvo, vođena veštačkom inteligencijom.“

– piše u izveštaju +972 Magazine

Zaključak:

Ako algoritam određuje ko umire, gde je granica između ratne efikasnosti i potpuno dehumanizovanog nasilja? Ako AI greši, ko je kriv?

🟡 Pitanje za vas:

Treba li AI da odlučuje o životu i smrti na bojnom polju?